Apache Spark — распределенная вычислительная система с открытым исходным кодом, предназначенная для обработки большого объема информации. Она предоставляет интерфейс для программирования целых кластеров компьютеров с неявным параллелизмом данных и отказоустойчивостью. То есть, Spark позволяет ускорить процесс анализа данных за счет распределения работы.

В этой статье мы расскажем, как установить программу Apache Spark в Ubuntu Linux.

Содержимое:

- Установка необходимых зависимостей

- Загрузка Apache Spark в Ubuntu

- Настройка среды приложения Spark

- Запуск автономного главного сервера Apache Spark

- Использование графического интерфейса Spark Web

- Выводы

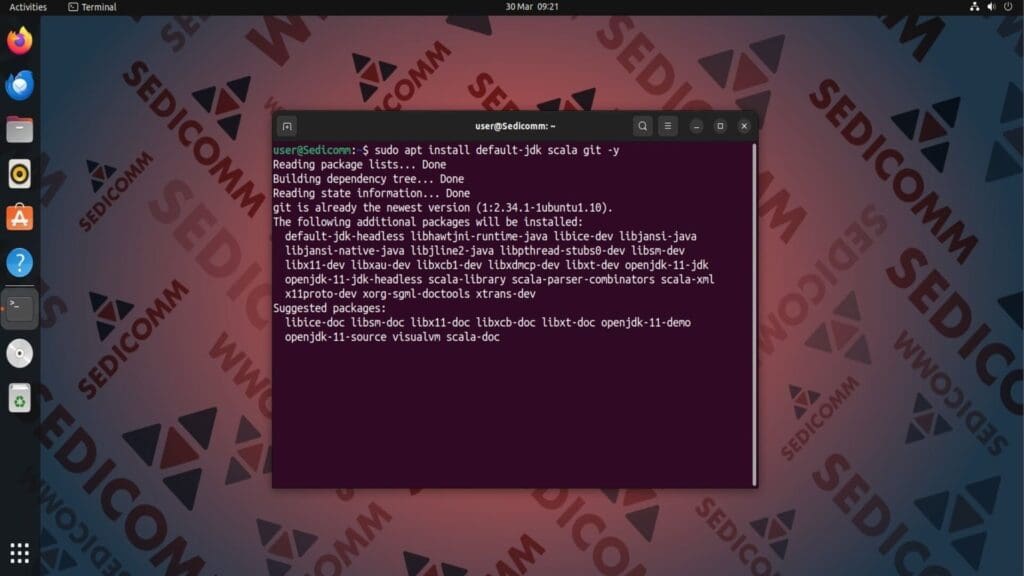

Установка необходимых зависимостей

Чтобы программа Apache Spark бесперебойно функционировала, следует установить ряд дополнительных инструментов:

- default-jdk — пакет JDK (сокр. от Java Development Kit), который позволяет создавать приложения на Java. Он включает в себя компилятор (

javac), отладчик (jdb) и другие утилиты. - Scala — язык программирования, который часто используется в связке с Apache Spark для написания приложений на этой вычислительной платформе.

- Git — система контроля версий, которая используется для управления репозиториями исходного кода, совместной разработки приложений.

Чтобы установить все перечисленные инструменты, выполните в терминале:

Затем проверьте версии установленных утилит, чтобы убедиться, что их инсталляция прошла успешно:

Читайте также: Как установить TensorFlow в CentOS Linux.

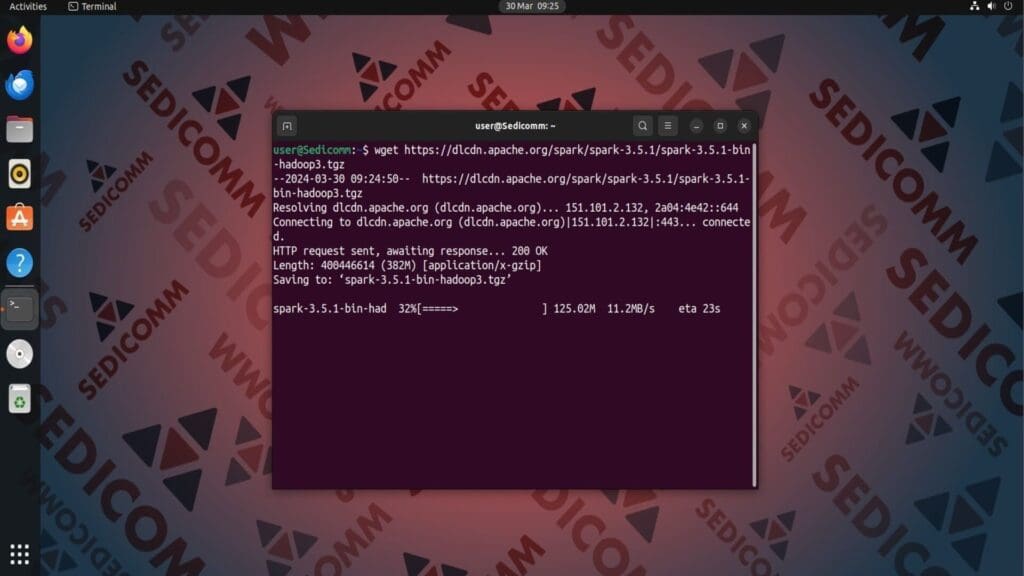

Загрузка Apache Spark в Ubuntu

Чтобы начать пользоваться Apache Spark, нужно скачать и распаковать архив с файлами этого программного обеспечения. На момент написания статьи доступны две версии инструмента: 3.4.2 и 3.5.1. Все ресурсы (исходные коды, бинарные сборки, документация и так далее) Spark хранятся на специальном сервере.

Для скачивания архива с файлами инструмента Apache Spark версии 3.5.1 примените команду wget:

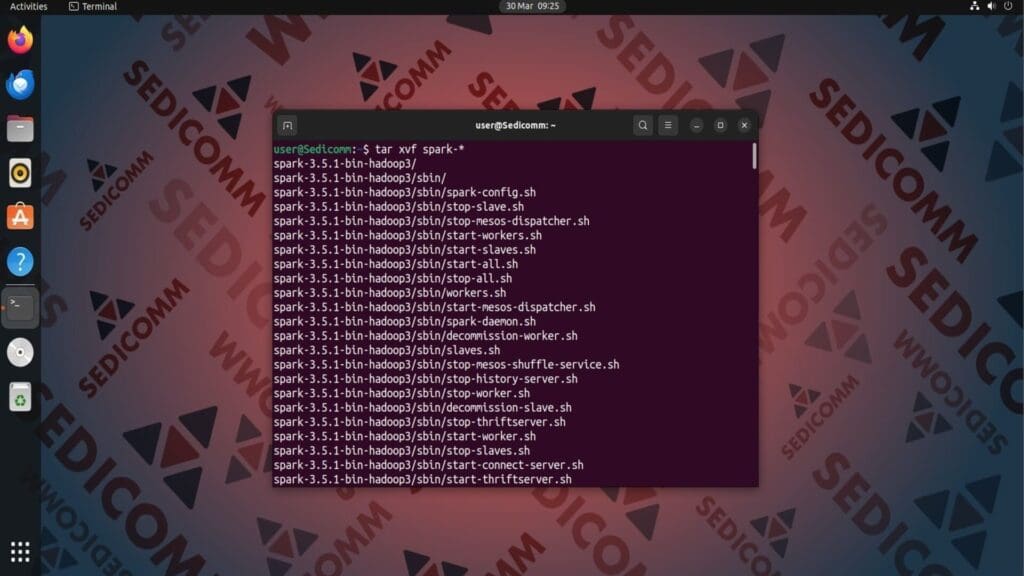

После чего извлеките файлы из архива с помощью утилиты tar:

Читайте также: Как установить Linux Dash.

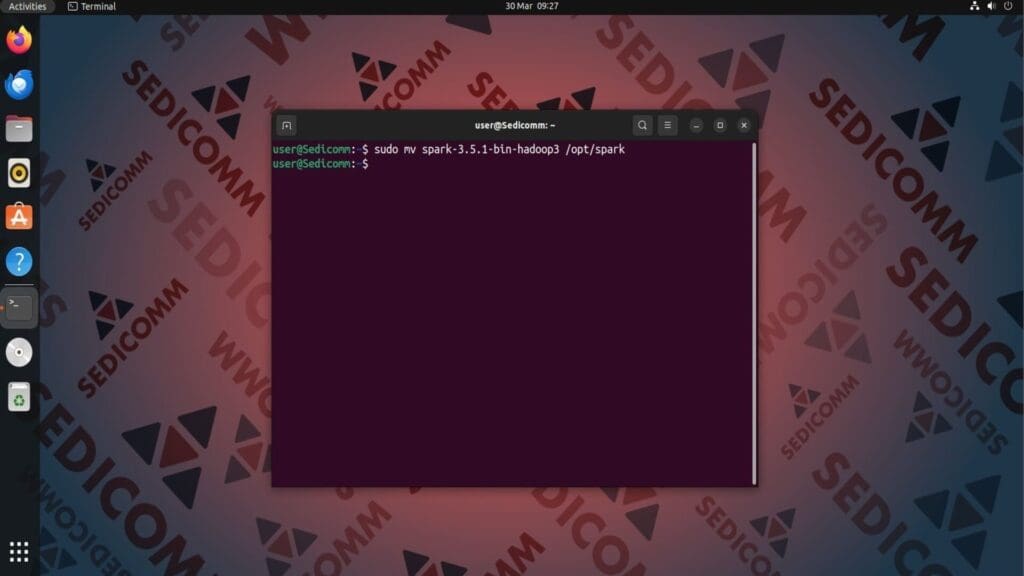

Наконец, переместите распакованную папку в директорию /opt/spark:

Настройка среды приложения Spark

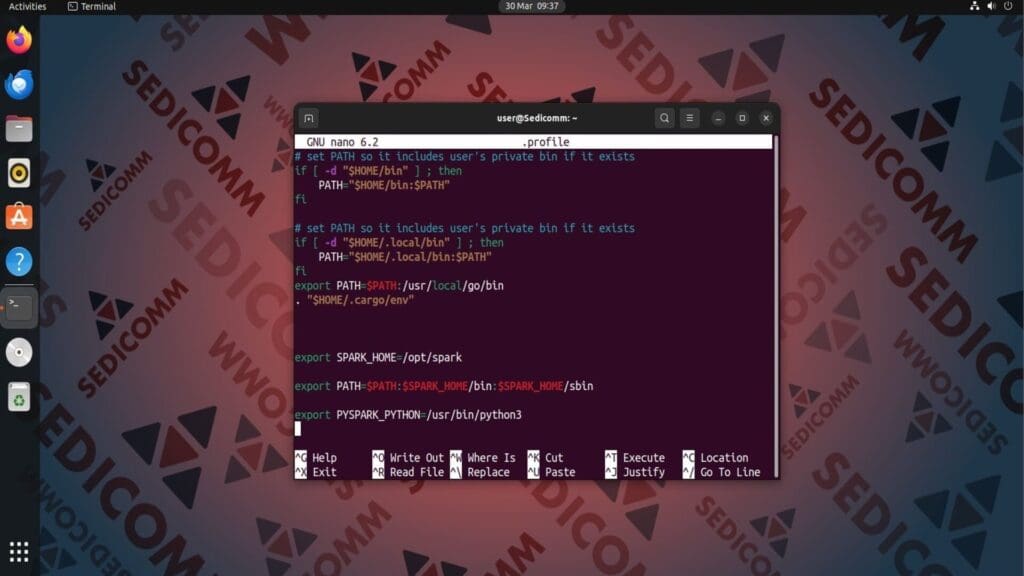

Перед запуском Apache Spark Вам нужно настроить переменные среды. Для этого откройте файл .profile с помощью текстового редактора, например, nano:

И вставьте в любое свободное место следующие строки:

Сохраните и закройте файл. Чтобы внесенные изменения вступили в силу немедленно, выполните в терминале:

Запуск автономного главного сервера Apache Spark

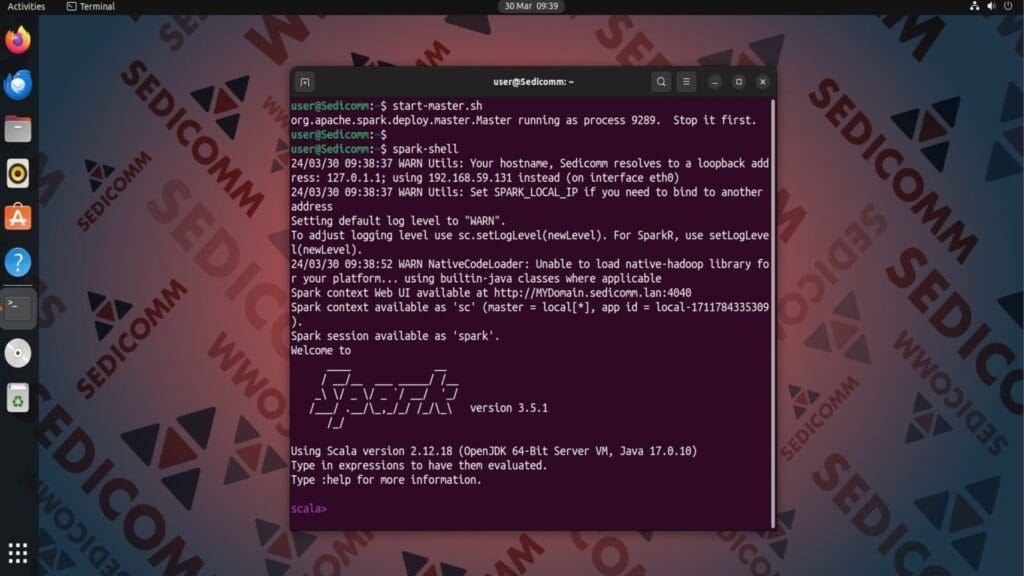

Теперь Вы можете включить главный сервер программы. Для этого запустите скрипт start-master.sh:

Чтобы использовать оболочку Spark в терминале, выполните следующую команду:

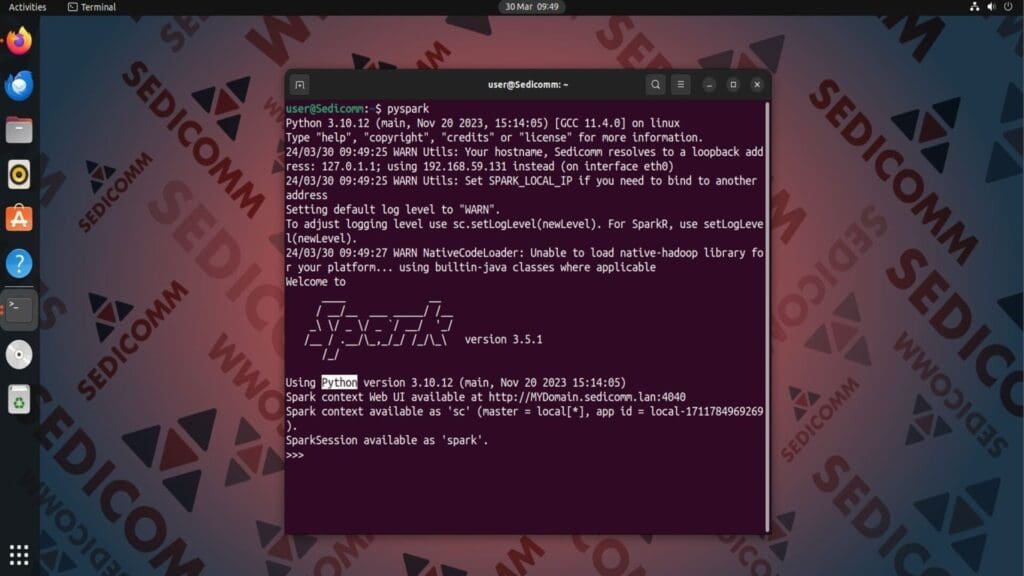

На скриншоте выше видно, что по умолчанию используется интерфейс терминала языка программирования Scala. Во время работы с Apache Spark Вы можете применять язык Python. Чтобы переключиться на него, для начала закройте текущую оболочку, выполнив команду :q. Затем запустите в командной строке Linux инструмент pyspark:

Чтобы выйти из этой оболочки, введите quit() и нажмите Enter.

Читайте также: Как правильно установить Python на Linux: разбор всех пунктов.

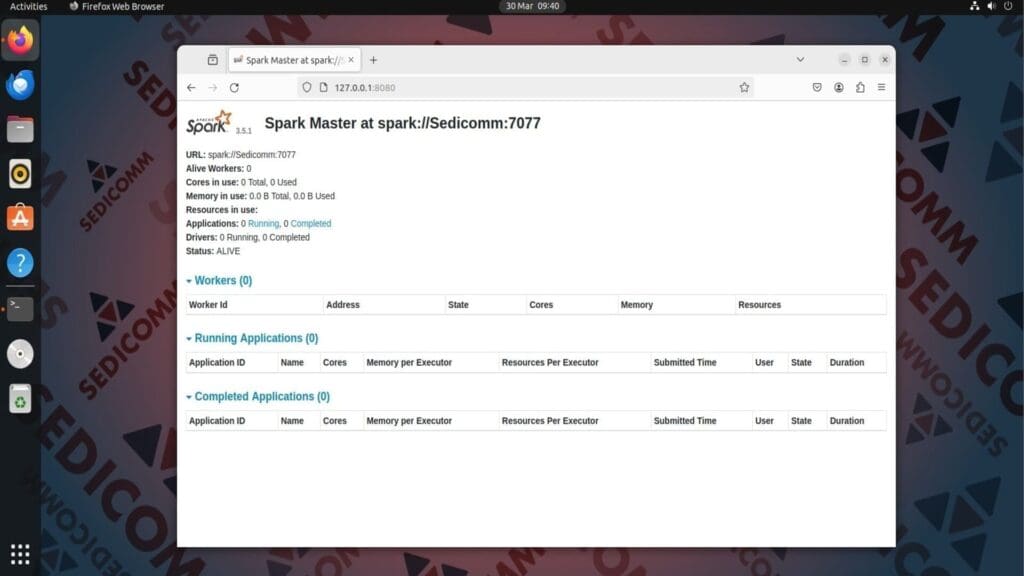

Использование графического интерфейса Spark Web

Программа Spark предоставляет пользовательский интерфейс. Чтобы получить к нему доступ, откройте веб-браузер и введите в поисковой строке следующий URL-адрес:

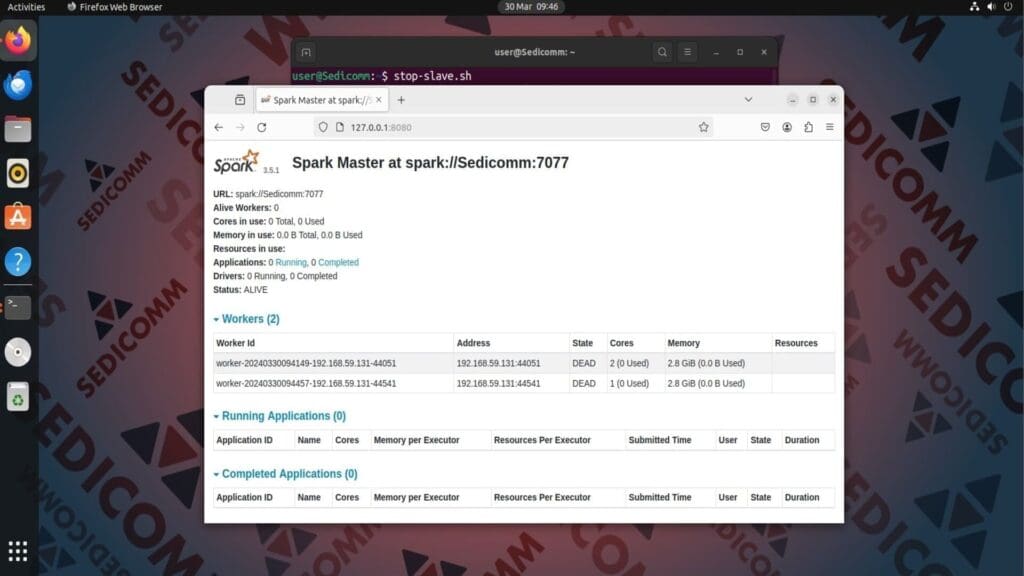

На главной странице отображается:

- URL-адрес главного сервера Spark (в нашем случае —

spark://Sedicomm:7077); - информация о статусе приложений и процессов, работающих / работавших на этой платформе;

- сведения о потреблении ресурсов ПК и ОС.

Запуск тестового рабочего процесса на сервере Spark

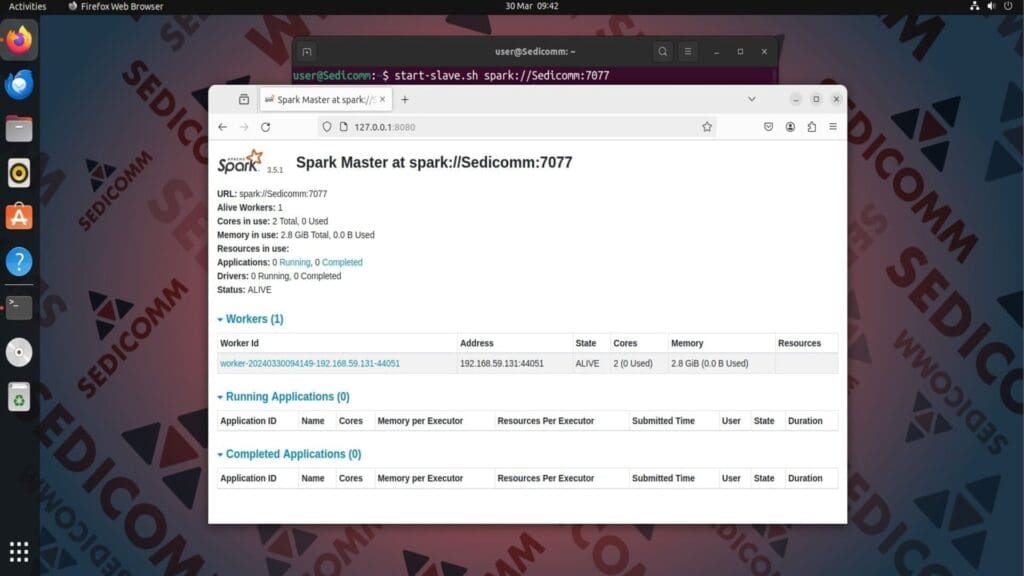

Давайте посмотрим, как управлять программами на сервере Spark. Например, Вы можете запустить тестовый дочерний процесс. Для этого выполните в терминале следующую команду:

Затем перезагрузите интерфейс Spark Web.

На скриншоте выше видно, что во вкладке Workers появилась запись, которая описывает сведения о дочернем процессе:

- идентификатор (

Worker Id) - URL-адрес (

Address); - состояние (

State); - количество используемых ядер ЦП (

Cores); - выделенный ему объем ОЗУ (

Memory); - другие ресурсы (

Resources).

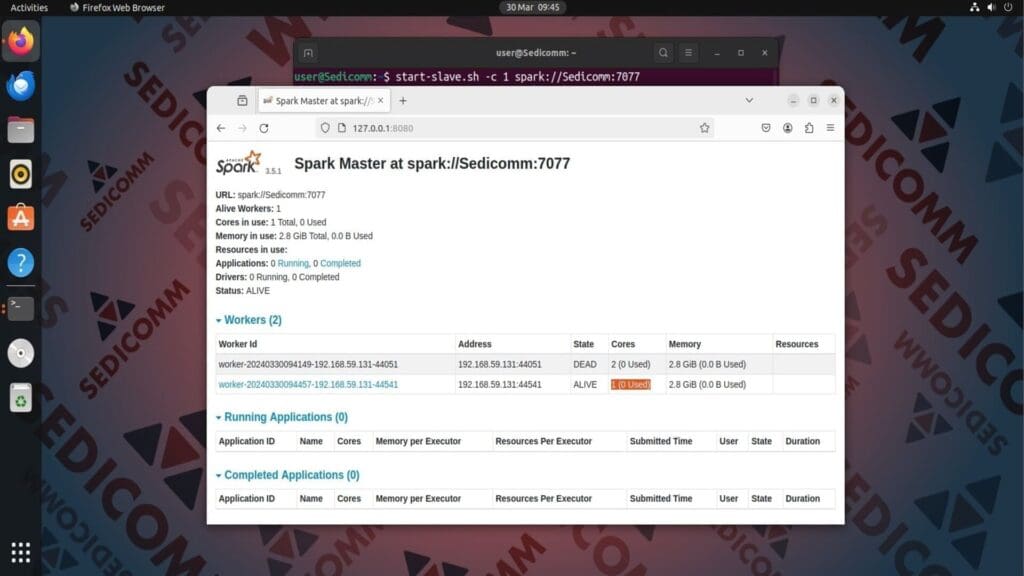

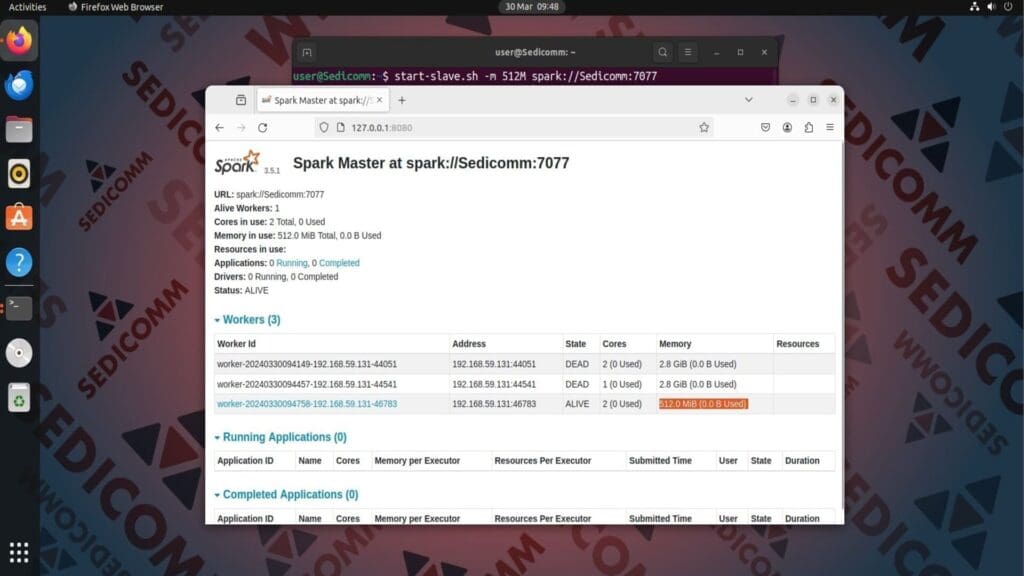

Распределение ресурсов для дочерних процессов

При запуске дочерних процессов Вы можете вручную выделять им ресурсы компонентов ПК или операционной системы. Чтобы назначить процессу определенное количество ядер ЦП, добавьте в предыдущую команду опцию -c. Например, чтобы выделить дочернему процессу одно ядро процессора, выполните в терминале:

Читайте также: Как посмотреть список модулей Apache в Linux.

Чтобы выделить процессу определенный объем оперативной памяти, примените опцию -m. В качестве ее аргумента укажите нужный объем ОЗУ в гигабайтах (G) или мегабайтах (M). Например:

Остановка главного сервера и рабочих процессов

Чтобы остановить запущенный рабочий процесс, выполните в терминале команду:

На скриншоте выше видно, что состояние процесса — DEAD.

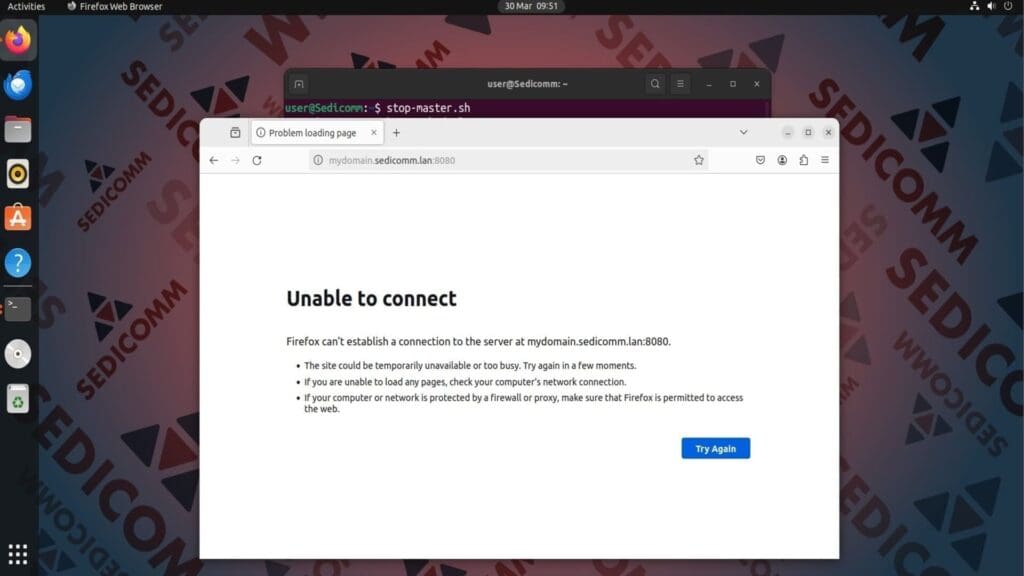

Чтобы остановить сервер Apache Spark, запустите в командной строке скрипт stop-master.sh:

Выводы

Процесс инсталляции Apache Spark в дистрибутиве Ubuntu Linux проходит в несколько этапов. Мы детально разобрали каждый из них, чтобы у Вас не возникло проблем при установке этого ПО. Также мы показали несколько команд для управления сервером Spark и его рабочими процессами.

Спасибо за время, уделенное прочтению статьи!

Если возникли вопросы — задавайте их в комментариях.

Подписывайтесь на обновления нашего блога и оставайтесь в курсе новостей мира инфокоммуникаций!

Чтобы знать больше и выделяться знаниями среди толпы IT-шников, записывайтесь на курсы Cisco, курсы по кибербезопасности, полный курс по кибербезопасности, курсы DevNet / DevOps (программируемые системы) от Академии Cisco, курсы Linux от Linux Professional Institute на платформе SEDICOMM University (Университет СЭДИКОММ).

Курсы Cisco, Linux, кибербезопасность, DevOps / DevNet, Python с трудоустройством!

- Поможем стать экспертом по сетевой инженерии, кибербезопасности, программируемым сетям и системам и получить международные сертификаты Cisco, Linux LPI, Python Institute.

- Предлагаем проверенную программу с лучшими учебниками от экспертов из Cisco Networking Academy, Linux Professional Institute и Python Institute, помощь сертифицированных инструкторов и личного куратора.

- Поможем с трудоустройством и стартом карьеры в сфере IT — 100% наших выпускников трудоустраиваются.

- Проведем вечерние онлайн-лекции на нашей платформе.

- Согласуем с вами удобное время для практик.

- Если хотите индивидуальный график — обсудим и реализуем.

- Личный куратор будет на связи, чтобы ответить на вопросы, проконсультировать и мотивировать придерживаться сроков сдачи экзаменов.

- Всем, кто боится потерять мотивацию и не закончить обучение, предложим общение с профессиональным коучем.

- отредактировать или создать с нуля резюме;

- подготовиться к техническим интервью;

- подготовиться к конкурсу на понравившуюся вакансию;

- устроиться на работу в Cisco по специальной программе. Наши студенты, которые уже работают там: жмите на #НашиВCisco Вконтакте, #НашиВCisco Facebook.